随着人工智能技术的飞速发展,大模型的部署变得日益重要。大模型通常指的是一些参数量巨大,能够处理复杂任务的深度学习模型,这些模型在自然语言处理、计算机视觉等领域发挥着巨大的作用。但要想有效地训练和运行这些大模型,对硬件特别是显卡有着极高的要求。本文将深入探讨部署大模型时对显卡的具体要求,并提供一些实用的建议。

显卡要求的概览

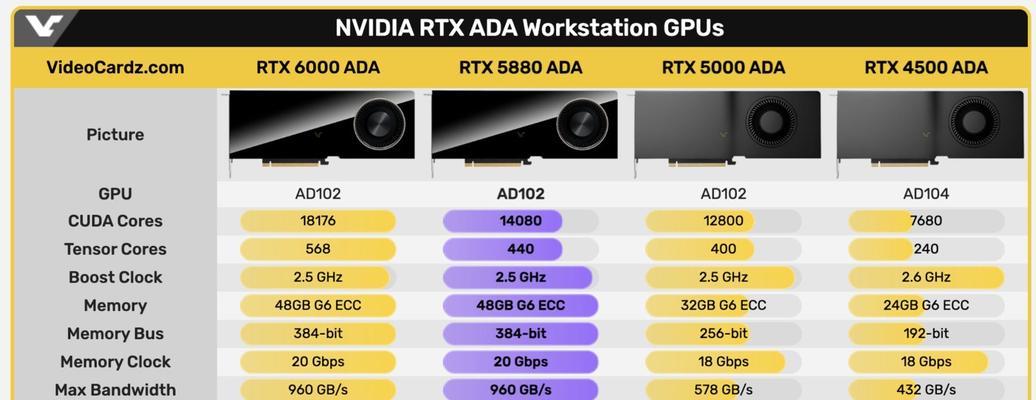

部署大模型首先需要考虑的是显卡的计算能力。大模型训练和推理过程中需要进行大量的矩阵运算,这要求显卡必须具备强大的GPU核心和高带宽的内存。大模型对显存容量也有较高的需求,以存储模型的参数以及中间数据。

显卡的计算能力

计算能力是衡量显卡性能的关键因素。对于大模型的部署,我们通常建议使用具有大量CUDA核心的NVIDIA显卡,例如Tesla或RTX系列。这些显卡提供了出色的并行处理能力,能够加速深度学习算法的训练过程。

显存容量

显存容量也是影响大模型部署的关键因素之一。大模型由于参数众多,需要较大的显存来存储。如果显存不足,可能会导致模型无法一次性加载到显卡中,从而需要分批处理,这会大大降低训练和推理的速度。在选择显卡时,尽量选择显存容量较大的型号。

显卡内存带宽

除了显存容量,显存的带宽也是不可忽视的因素。高带宽意味着数据可以更快地在显卡内存和GPU核心之间传输,这对于那些需要频繁访问大量数据的大模型训练来说至关重要。选择具有高内存带宽的显卡可以有效提升训练和推理的速度。

显卡的散热与功耗

长期运行大模型训练会使得显卡产生大量热量,因此散热性能是确保显卡稳定运行的重要因素。同时,功耗也是不可忽视的问题,尤其是对于数据中心来说,高功耗会增加运行成本。选择散热效果好、功耗适中的显卡有助于提高整体效率。

具体显卡推荐

根据上述要求,我们可以推荐几款适合部署大模型的显卡。NVIDIA的A100GPU,它拥有极高的计算性能和显存容量,以及卓越的内存带宽,非常适合大规模深度学习任务。对于预算相对有限的用户,RTX系列的显卡如RTX3090也是一个不错的选择,它提供了相对较高的性能和容量,同时保持了较好的性价比。

其他硬件考量

除了显卡之外,还需要关注其他硬件组件。高速的SSD硬盘能够加快数据的读写速度;多核的CPU可以帮助处理一些并行的辅助任务;高效率的电源供应则能保证系统稳定运行。

结语

综上所述,部署大模型对显卡的要求非常高,需要在计算能力、显存容量、内存带宽、散热和功耗等方面进行综合考量。选择合适的显卡,配合其他硬件的优化,可以大幅提高大模型训练和推理的效率,让深度学习应用更加流畅。希望本文能够为您在选择显卡时提供有价值的参考。